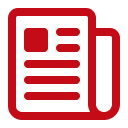

Markt für Speicher mit hoher Bandbreite: Nach Produkt (Zentraleinheit, FPGA, Grafikprozessor, anwendungsspezifischer integrierter Schaltkreis und Sonstige); Anwendung (Hochleistungsrechnen (HPC), Netzwerk- und Client-Umgebungen, Rechenzentren und Sonstige); und Region – Branchendynamik, Marktgröße und Potenzialprognose für 2025–2033

- Zuletzt aktualisiert: 30. Januar 2025 | | Bericht-ID: AA0322178

Marktdynamik

Der Markt für Speicher mit hoher Bandbreite steht vor einem signifikanten Wachstum. Es wird erwartet, dass die Umsätze von 501,0 Millionen US-Dollar im Jahr 2024 auf 5.810,5 Millionen US-Dollar im Jahr 2033 steigen werden, was einer durchschnittlichen jährlichen Wachstumsrate (CAGR) von 31,3 % im Prognosezeitraum 2025-2033 entspricht.

Hochbandbreitenspeicher (HBM) steht ab 2024 im Zentrum der grundlegenden Veränderungen in der Rechenleistung. AMD stellte seine MI300-Serie vor, die in sorgfältig konzipierten Serverumgebungen Spitzendatenraten von bis zu 5 Terabyte pro Sekunde erreicht. SK hynix präsentierte einen HBM3-Prototyp mit einer Übertragungsrate von 819 Gigabit pro Sekunde pro Stack in ausgewählten HPC-Modulen. NVIDIA setzte HBM2E in seinen Flaggschiff-GPUs für Rechenzentren ein und erreichte damit eine Speicherfrequenz von 2,4 GHz in gezielten KI-Anwendungen. HPC-Labore in Deutschland berichteten von einer Latenzverbesserung von 21 Nanosekunden mit neueren HBM3-Bausteinen, während Samsung Mitte 2024 eine HBM-Produktreihe mit 24 Gigabit pro Schicht zur Unterstützung neuer Deep-Learning-Anwendungen vorstellte. Die Entwicklung beschleunigte sich weiter, als der Supercomputer Leonardo in Italien 74 AMD-Beschleuniger mit integriertem HBM für Klimasimulationen einsetzte. Jeder Beschleuniger verfügt über rund 15 Gigabyte fortschrittlichen Speicher für Echtzeitanalysen.

Ein in Tokio ansässiges KI-Startup im Markt für Hochbandbreitenspeicher nutzte neun NVIDIA H100 GPUs mit HBM2E-Speicher, um umfangreiche Deep-Learning-Aufgaben zu bewältigen. Auf einer HPC-Konferenz 2024 wurde ein HBM-basierter Chip demonstriert, der in speicherintensiven Workflows 2,78 Terabyte pro Sekunde erreichte. Da HBM durch sein Design den Energieverbrauch pro übertragenem Bit reduziert, setzen viele KI-orientierte Unternehmen auf diese Technologie für zukünftige HPC-Projekte. Das große Interesse an HBM beruht auf seiner Fähigkeit, die Grenzen herkömmlicher Speicher für datenintensive Operationen deutlich zu überwinden. Forscher sehen signifikante Leistungssteigerungen bei Strömungssimulationen, Genomanalysen und anderen Szenarien, die einen konstant hohen Durchsatz erfordern. Einst auf Nischengeräte beschränkt, findet HBM nun breite Beachtung, da es Probleme der Spannungsregelung, des Wärmemanagements und der Energieeffizienz löst, ohne die Geschwindigkeit zu beeinträchtigen. Branchenexperten erwarten eine weitere Hardware-Software-Kooptimierung, um das volle Potenzial von HBM auszuschöpfen und deuten auf eine nahe Zukunft mit integrierten, energieeffizienten Computerlösungen hin. Diese Entwicklungen ebnen den Weg, auf dem fortschrittliche Speicherschnittstellen als wesentliche Säulen für bahnbrechende HPC-Entwicklungen der nächsten Generation dienen und sicherstellen, dass HBM seine Position als wichtiges Unterscheidungsmerkmal in modernen datengetriebenen Märkten behält.

Um weitere Einblicke zu erhalten, fordern Sie ein kostenloses Muster an

Blitzschnelle Erweiterung der Produktionslinien

Die Produktionskapazitäten im globalen Markt für Speichermodule mit hoher Bandbreite (HBM) haben in den letzten Jahren rasant zugenommen, da verschiedene Hersteller versuchen, die steigende Nachfrage nach fortschrittlichen Speicherlösungen zu decken. Samsung plant, seine maximale HBM-Produktion bis zum vierten Quartal 2024 auf 150.000 bis 170.000 Einheiten pro Monat zu steigern. Parallel dazu strebt Micron an, seine HBM-Produktionskapazität im Werk Hiroshima im gleichen Zeitraum auf 25.000 Einheiten zu erhöhen. Die kombinierte Produktionskapazität der drei größten Hersteller – Samsung, SK Hynix und Micron – wird voraussichtlich bis 2025 rund 540.000 Einheiten pro Monat erreichen. Der kontinuierliche Ausbau der Produktionskapazitäten wird auch durch die expandierende Rechenzentrumsinfrastruktur begünstigt. Allein in den Vereinigten Staaten gibt es 2.670 Rechenzentren, gefolgt von Großbritannien mit 452 und Deutschland mit 443.

Um den steigenden Produktionsmengen gerecht zu werden, modernisieren die wichtigsten Akteure im Markt für Speicher mit hoher Bandbreite ihre bestehenden Produktionsanlagen und errichten neue. Samsung erweitert seine Werke in Pyeongtaek, Südkorea, um die Produktion von DDR5 und HBM zu steigern und so eine stabilere Lieferkette für diese Technologie zu gewährleisten. SK Hynix betreibt weiterhin seine M16-Produktionslinie in Icheon für HBM und baut zudem eine neue Produktionsstätte in Indiana, USA, um HBM-Speicherchips speziell für NVIDIA-GPUs herzustellen. Micron wiederum investiert weiterhin in den Ausbau seiner Produktionskapazitäten im Werk Hiroshima, Japan, und nutzt dabei die etablierte Fertigungskompetenz der Region. Diese Expansionen unterstreichen die gemeinsamen Bemühungen der Marktführer, technologisch führend zu bleiben und die weltweit steigende Nachfrage zu befriedigen. Durch umfassende Investitionen in die Infrastruktur schaffen die Unternehmen die Voraussetzungen für eine neue Ära der Speichertechnologie und beschleunigen deren Einführung in Branchen, die auf modernste Rechenleistung angewiesen sind.

Marktdynamik

Treiber: Unermüdliches Streben nach Höchstgeschwindigkeiten für spezialisierte HPC-Architekturen mit integrierten modernen Speicherlösungen

Das ständige Streben nach Höchstgeschwindigkeiten für spezialisierte HPC-Architekturen mit integrierten modernen Speicherlösungen resultiert aus dem permanenten Bedarf, enorme Datenmengen und hochkomplexe Berechnungen zu verarbeiten. Führende Chiphersteller im Markt für Speicher mit hoher Bandbreite (HBM) haben neue HBM-Module speziell für Aufgaben wie Klimamodellierung, autonome Systeme und Quantensimulationen vorgestellt. Intel präsentierte 2024 einen Prototyp-Beschleuniger, der einen kontinuierlichen Durchsatz von 1,9 Terabyte pro Sekunde bei speicherintensiven KI-Inferenzen demonstrierte. Entwickler des HPC-Zentrums in Bangalore berichteten, dass ein HBM-basierter Ansatz die Simulationslaufzeiten für bestimmte groß angelegte Fluiddynamikprojekte auf 19 Minuten reduzierte. Graphcore bestätigte, dass seine experimentelle IPU mit HBM in der Lage war, in speziellen Verschlüsselungstests eine Million Graphkanten in 2 Sekunden zu verarbeiten. Diese Fortschritte unterstreichen die Dringlichkeit des Marktes, schnellere, bandbreitenorientierte Speicherlösungen einzuführen, die die Leistung in HPC-Clustern deutlich steigern.

Dieses Streben nach beschleunigter Leistung überschneidet sich mit dem Aufkommen von Multi-Die-Packaging, das eine flexiblere Integration von Rechen- und Speicherkomponenten ermöglicht. Fujitsus neu entwickelter HPC-Knoten nutzte ein HBM-Subsystem, das 19 Gigabyte Daten in einer Sekunde Dauerbetrieb übertrug und damit neue Wege für die Analyse der Proteinfaltung eröffnete. TSMC hat einen speziellen Interposer mit Mikro-Bumps im Abstand von 30 Mikrometern entwickelt, um ultraschnelle Signalübertragungen in HBM-basierten Designs zu ermöglichen. Ein weiteres bemerkenswertes Beispiel im Markt für Speicher mit hoher Bandbreite ist ein astrophysikalisches Institut in Frankreich, das durch den Einsatz eines HBM-basierten Systems mit einer mittleren Latenz von 110 Nanosekunden Pulsardaten in Echtzeit analysierte. Durch die Optimierung von Verbindungen und Systemtopologien stellt die Branche sicher, dass HBM weiterhin eine zentrale Rolle im Fortschritt von HPC spielt und dessen Verbreitung auf absehbare Zeit maßgeblich vorantreibt.

Trend: Zunehmende Nutzung integrierter Beschleuniger-Speicher-Plattformen zur Ermöglichung von Synergien zwischen fortgeschrittenem Deep Learning und HPC

Im Bereich der Speicher mit hoher Bandbreite zeichnet sich ein zunehmender Trend ab: die verstärkte Nutzung von integrierten Beschleuniger-Speicher-Designs, die den Datenfluss für KI-, HPC- und Edge-Workloads optimieren. AMDs Instinct-Beschleuniger verfügen seit Kurzem über eine integrierte HBM-Lösung, die Hochdurchsatzberechnungen für die Molekülmodellierung in Schweizer Laboren unterstützt. Xilinx, mittlerweile Teil von AMD, präsentierte einen FPGA-Prototyp (Field-Programmable Gate Array), der einen nahezu verzögerungsfreien Datenaustausch zwischen Logik und HBM ermöglicht und so den gleichzeitigen Betrieb mehrerer neuronaler Netze im Markt für Speicher mit hoher Bandbreite erlaubt. Cerebras demonstrierte eine Wafer-Scale-Engine in Kombination mit dichten HBM-Modulen, die mehr als 2,5 Millionen Parameter in Reinforcement-Learning-Aufgaben ohne externe Datenübertragungen verarbeiten kann. Diese Verbindung von Beschleunigung und Hochgeschwindigkeitsspeicher läutet eine neue Ära der Recheneffizienz ein und fördert fortschrittliche Lösungen für datenintensive Branchen.

Mit der Weiterentwicklung der Branche werden spezialisierte Frameworks und Bibliotheken zunehmend für die Nutzung eng vernetzter Speicherkanäle optimiert. Der fortschrittliche HPC-Cluster von OpenAI nutzte eine HBM-fähige Architektur für das Training umfangreicher Sprachmodelle mit bis zu zwei Billionen Token in einem einzigen kontinuierlichen Durchlauf. Ein weiteres Highlight im Markt für Speicher mit hoher Bandbreite lieferten Robotikforscher aus Peking, die die Synergie von HBM und GPU-Rechenleistung nutzten, um in humanoiden Controllern Entscheidungen im Submillisekundenbereich zu treffen. Die HPC-Abteilung von Alibaba Cloud berichtete, dass HPC-Instanzen der nächsten Generation mit HBM bei verschlüsselungsbasierten Aufgaben eine Bandbreitenauslastung von 98 Gigabyte pro Sekunde erreichten. Diese Beispiele unterstreichen den tiefgreifenden Wandel hin zu integrierten Beschleuniger-Speicher-Ökosystemen und markieren einen entscheidenden Wendepunkt in HPC und KI. Gleichzeitig legen sie den Grundstein für zukünftige Durchbrüche in der Echtzeit-Datenanalyse.

Herausforderung: Reduzierung der thermischen Belastung in gestapelten Chiparchitekturen zur Gewährleistung der Stabilität von Speichern mit kontinuierlich hoher Bandbreite

Eine wesentliche Herausforderung im Markt für Speicher mit hoher Bandbreite (HBM) besteht in der Kontrolle der Wärmeentwicklung in dicht gestapelten Speicherschichten. Chiphersteller beobachten, dass längere HPC-Aufgaben zu einer erheblichen Wärmeentwicklung führen, die sowohl die Zuverlässigkeit als auch die Leistung beeinträchtigt. Ein japanisches Simulationszentrum für die Luft- und Raumfahrt dokumentierte durchschnittliche Temperaturen von 83 Grad Celsius in HBM-Komponenten während mehrstündiger aerodynamischer Analysen. Um diesem Problem zu begegnen, entwickelte Samsung ein spezielles Wärmeleitmaterial, das die Temperatur in sorgfältig getesteten HPC-Knoten um etwa 8 Grad senkt. Eine israelische Verteidigungsforschungseinrichtung validierte eine Wasserkühlung, die einen stabilen Speicherbetrieb über mindestens 72 Stunden kontinuierlicher kryptografischer Verarbeitung gewährleistete. Diese Ergebnisse bestätigen, dass die Reduzierung der Wärmeentwicklung weiterhin höchste Priorität hat, um sicherzustellen, dass gestapelte Strukturen keine Leistungseinbußen oder Bauteilverschlechterungen erleiden.

Lösungen für das Wärmemanagement im Markt für Speicher mit hoher Bandbreite (HBM) beeinflussen Formfaktor und Systemarchitektur, da HBM in unmittelbarer Nähe zu Rechenressourcen platziert ist. SK hynix hat eine HBM2E-Variante mit einem Mikroschicht-Kühlkanal vorgestellt, der 1,1 Liter Flüssigkeit pro Stunde transportiert und so Hotspots bei KI-Inferenz verhindert. Ein amerikanisches HPC-Konsortium testete eine Dampfkammertechnologie in der Nähe des Speicherstapels und erreichte eine konstante Bandbreite bei umfangreichen Workloads mit Datensätzen von bis zu 2,3 Petabyte. Ingenieure eines belgischen Forschungsinstituts stellten fest, dass die Fehlerrate von HBM ohne fortschrittliche Kühlung unter Stressbedingungen auf 19 Fehler pro Million Transaktionen anstieg. Die Bewältigung dieser Herausforderungen erfordert innovative Materialwissenschaften, Präzisionstechnik und eine robuste Systemvalidierung, die gemeinsam eine stabile Leistung in anspruchsvollen HPC-Implementierungen der nächsten Generation gewährleisten.

Segmentanalyse

Nach Produkt: Die Dominanz von CPUs wird bis 2033 anhalten

Zentralprozessoren (CPUs) dominieren den Markt für Speicher mit hoher Bandbreite mit einem Anteil von 35,4 %. Grund dafür ist ihre zentrale Rolle bei der Orchestrierung komplexer Rechenaufgaben in KI-, Analyse- und HPC-Umgebungen (High-Performance Computing). Durch die Kombination von HBM mit CPUs erzielen Unternehmen Datendurchsatzkapazitäten, die herkömmliche Speicherstandards übertreffen und in bestimmten HPC-Umgebungen mehr als eine Billion Datenoperationen pro Minute ermöglichen. Die 3D-gestapelte Architektur von HBM unterstützt bis zu acht DRAM-Module in einem einzigen Stapel, die jeweils über zwei Kanäle für einen ungehinderten Datenfluss verbunden sind. In modernen CPU-Designs ermöglicht diese Konfiguration Übertragungsgeschwindigkeiten von bis zu 1 TB/s, was Aufgaben wie das Training von Modellen für maschinelles Lernen erheblich beschleunigt. Darüber hinaus nutzen einige CPU-HBM-Lösungen der nächsten Generation Busbreiten von bis zu 1024 Bit, wodurch die simultane Übertragung von über 100 Milliarden Bit Daten vom Speicher zur CPU nahezu in Echtzeit möglich ist. Diese technischen Eigenschaften sichern die führende Position von CPUs in diesem Bereich.

Die steigende Nachfrage nach HBM-basierten CPUs im Markt für Speicher mit hoher Bandbreite ist auch auf deren Beitrag zur Reduzierung von Latenz und Stromverbrauch im Vergleich zu parallelen Speichersystemen zurückzuführen. In datenintensiven Anwendungen kann eine einzelne CPU-HBM-Kombination die Speicherbandbreite um über 40 % gegenüber herkömmlichen DDR-basierten Architekturen verbessern und so Arbeitsabläufe in der wissenschaftlichen Forschung und Finanzmodellierung erheblich beschleunigen. Ein weiterer quantitativer Vorteil liegt in der potenziellen 2- bis 3-fachen Steigerung der Gleitkomma-Berechnungen, sobald HBM eng mit den Kern-Pipelines der CPU integriert ist. Dies erhöht den reinen Rechendurchsatz des Systems. Diese Synergie beseitigt Speicherengpässe, schützt Systeme vor der „Speicherwand“ und stellt sicher, dass kritische Daten mit optimaler Geschwindigkeit übertragen werden. Angesichts des akuten HBM-Lieferengpasses in der gesamten Branche priorisieren führende CPU-Hersteller die HBM-Integration, um auch in Prozessoren der nächsten Generation führende Leistungskennzahlen zu gewährleisten. Diese Faktoren sichern CPUs die Position als wichtigste Produktkategorie, die die außergewöhnliche Bandbreite und die geringen Latenzeigenschaften von HBM im modernen Computing nutzt.

Anwendung: Rechenzentren als größter Abnehmer des Marktes für Speichermedien mit hoher Bandbreite

Dank des explosionsartigen Anstiegs der Datenmengen, die in Cloud Computing, KI-Inferenz und Hyperscale-Analytics verarbeitet werden, haben sich Rechenzentren mit einem Umsatzanteil von über 38,4 % zum größten Abnehmer von Speicher mit hoher Bandbreite (HBM) entwickelt. In vielen Einrichtungen setzen Systemarchitekten Serverdesigns ein, die HBM integrieren, um Abfragepipelines mit bis zu 500 Millionen Echtzeit-Abfragen pro Sekunde zu unterstützen und so geschäftskritische Datenbanken und Content Delivery Networks (CDNs) zu optimieren. In bestimmten Konfigurationen kann jedes Serverrack mehrere HBM-basierte Beschleunigerkarten enthalten, wodurch in umfassenden Implementierungen eine aggregierte Bandbreite von über 5 TB/s erreicht wird. Durch den Einsatz von gestapeltem Speicher reduzieren Rechenzentren zudem den physischen Platzbedarf von Speicherlösungen um bis zu 30 % und schaffen so Raum für zusätzliche Rechenleistung. Mit Geschwindigkeiten von bis zu 1 TB/s pro HBM-Stack werden massive Parallelverarbeitungsaufgaben – wie Videotranskodierung oder umfangreiche Echtzeitanalysen – mit höherer Effizienz und geringeren Durchsatzverzögerungen ausgeführt.

Ein weiterer Faktor für die zunehmende Verbreitung von Speichermedien mit hoher Bandbreite in Rechenzentren ist der wachsende Fokus auf KI-gestützte Workloads. Das Training eines einzelnen Deep-Learning-Modells kann Milliarden von Parametern umfassen und benötigt im täglichen Betrieb mehrere Terabyte Speicherbandbreite. Durch den Einsatz von HBM in Serverclustern konnten Unternehmen Inferenzvorgänge um mehr als 25 % beschleunigen und die Datenverarbeitungszeiten im Vergleich zu herkömmlichen DRAM-basierten Systemen messbar reduzieren. Selbst anspruchsvolle Anwendungen wie Transaktionsdatenbanken profitieren von einer deutlichen Steigerung der Speicherleistung. In bestimmten Implementierungen werden die Lese- und Schreiblatenzen im Vergleich zu Standard-Speicherlösungen um fünf Mikrosekunden gesenkt. Darüber hinaus reduziert HBM den Stromverbrauch in großen Rechenzentren um etwa 10 % pro Speicherkomponente. Dies spart den Einrichtungen jährlich Zehntausende Kilowattstunden und unterstützt die Nachhaltigkeitsziele.

Passen Sie diesen Bericht an + validieren Sie es mit einem Experten

Greifen Sie nur auf die Abschnitte zu, die Sie benötigen-regionspezifisch, Unternehmensebene oder nach Anwendungsfall.

Beinhaltet eine kostenlose Beratung mit einem Domain -Experten, um Ihre Entscheidung zu leiten.

Um mehr über diese Forschung zu erfahren, fordern Sie eine kostenlose Probe an

Regionale Analyse: Asien-Pazifik als größter Markt für Speicher mit hoher Bandbreite

Der asiatisch-pazifische Raum ist führend im Bereich der Hochbandbreitenspeicher (HBM). Dies ist auf ein Zusammenspiel starker Produktionsnetzwerke, einer robusten Nachfrage nach Unterhaltungselektronik und massiver staatlicher Förderung der Halbleiterforschung und -entwicklung zurückzuführen. Die Region dürfte in den kommenden Jahren ein starkes jährliches Wachstum von 37,7 % verzeichnen. Im Jahr 2022 erwirtschaftete die Region einen Umsatz von über 55,24 Millionen US-Dollar, der bis 2024 voraussichtlich 198,20 Millionen US-Dollar erreichen wird. Damit hat die Region die Marktführerschaft Nordamerikas überholt. Wichtige Akteure wie Samsung Electronics und SK Hynix betreiben hochmoderne Produktionsanlagen, die zusammen Millionen von HBM-Einheiten pro Quartal herstellen und die Region zu einem Zentrum für Spitzenspeicherproduktion machen. Zu den Ländern, die diese Entwicklung vorantreiben, gehören China, Südkorea und Japan. Jede dieser drei verfügt über hochentwickelte Lieferketten, die in der Lage sind, HBM-Technologie sowohl auf dem Inlands- als auch auf dem Weltmarkt anzubieten. In ganz China haben politische Anreize die Entwicklung neuer Produktionsanlagen gefördert, die bis zu 200.000 Siliziumwafer pro Monat herstellen können – eine Zahl, die stetig wächst, da das Land seine Selbstversorgung mit Halbleiterkomponenten ausbauen will. Südkoreas führende Rolle in der Speicherforschung und Japans Präzisionsfertigungskompetenz bilden zusammen ein Trio regionaler Stärken. Diese Konstellation sichert dem asiatisch-pazifischen Raum eine zentrale Rolle bei der Auslieferung von Speicherlösungen für Unternehmen und stärkt die Vormachtstellung der Region in der HBM-Produktion.

Die Nachfrage nach Speichermodulen mit hoher Bandbreite im asiatisch-pazifischen Raum (APAC) resultiert aus dem rasanten Anstieg von KI-Workloads und HPC-Implementierungen in verschiedensten Branchen – von der Biotechnologie bis zum autonomen Fahren. Diese erfordern Speichermodule, die über 500 Millionen Datentransaktionen pro Sekunde verarbeiten können. Zudem finden viele der weltweit größten Rechenzentrumserweiterungen in APAC statt, wo große Unternehmen HBM einsetzen, um den Stromverbrauch im Vergleich zu herkömmlichen Speicherschnittstellen um 15–20 Watt pro Modul zu senken. Insbesondere China hat sich durch den Ausbau von HPC-Clustern in Sektoren wie der Genomsequenzierung und der Wettervorhersage zu einem strategischen Vorreiter entwickelt. Dies erfordert extrem schnelle Speicherlösungen für Datensimulationsaufgaben. Führende Unternehmen wie Samsung, SK Hynix und die regionalen Niederlassungen von Micron arbeiten kontinuierlich an der Weiterentwicklung von Technologien der nächsten Generation, wie beispielsweise HBM3E, um höhere Speicherdichten und Datenübertragungsgeschwindigkeiten von bis zu 1,4 TB/s in zukünftigen Versionen zu erreichen. Mit seinen umfangreichen Hightech-Industriebasen befriedigt der asiatisch-pazifische Raum nicht nur den Inlandsbedarf, sondern liefert auch große Mengen an HBM weltweit und festigt damit seine Position als führende Region für Innovation und Lieferung von Hochbandbreitenspeichern.

Führende Unternehmen auf dem Markt für Speicher mit hoher Bandbreite:

- Advanced Micro Devices, Inc.

- Samsung Electronics Co., Ltd.

- SK Hynix Inc.

- Micron Technology, Inc.

- Rambus.com

- Intel Corporation

- Xilinx Inc.

- Open-Silicon (SiFive)

- NEC Corporation

- Cadence Design Systems, Inc.

- Andere prominente Spieler

Überblick über die Marktsegmentierung:

Nach Produkt:

- Zentrale Verarbeitungseinheit

- Feldprogrammierbares Gate-Array

- Grafikprozessor

- Anwendungsspezifischer integrierter Schaltkreis

- Andere

Per Antrag:

- Hochleistungsrechnen (HPC)

- Netzwerk- und Kundenbereich

- Rechenzentren

- Andere

Nach Region:

- Nordamerika

- Die USA

- Kanada

- Mexiko

- Europa

- Großbritannien

- Deutschland

- Frankreich

- Italien

- Spanien

- Polen

- Russland

- Restliches Europa

- Asien-Pazifik

- China

- Indien

- Japan

- Australien und Neuseeland

- ASEAN

- Rest des asiatisch-pazifischen Raums

- Naher Osten und Afrika (MEA)

- Vereinigte Arabische Emirate

- Saudi-Arabien

- Südafrika

- Rest von MEA

- Südamerika

- Argentinien

- Brasilien

- Rest von Südamerika

BERICHTSUMFANG

| Berichtsattribut | Einzelheiten |

|---|---|

| Marktgrößenwert im Jahr 2024 | 501,0 Mio. US$ |

| Erwarteter Umsatz im Jahr 2033 | 5.810,5 Mio. US$ |

| Historische Daten | 2020-2023 |

| Basisjahr | 2024 |

| Prognosezeitraum | 2025-2033 |

| Einheit | Wert (USD Mio.) |

| CAGR | 31.3% |

| Abgedeckte Segmente | Nach Produkt, nach Anwendung, nach Region |

| Schlüsselunternehmen | Advanced Micro Devices, Inc., Samsung Electronics Co., Ltd., SK Hynix Inc., Micron Technology, Inc., Rambus.com, Intel Corporation, Xilinx Inc., Open-Silicon (SiFive), NEC Corporation, Cadence Design Systems, Inc., Weitere namhafte Akteure |

| Anpassungsumfang | Erhalten Sie Ihren individuellen Bericht nach Ihren Wünschen. Fragen Sie nach einer Anpassung |

Sie suchen umfassende Marktkenntnisse? Beauftragen Sie unsere erfahrenen Spezialisten.

SPRECHEN SIE MIT EINEM ANALYSEN

.svg)