Mercado de memoria de alto ancho de banda: por producto (unidad de procesamiento central, matriz de compuerta programable para campo, unidad de procesamiento de gráficos, circuito integrado específico de la aplicación y otros); Aplicación (computación de alto rendimiento (HPC), redes y espacio de clientes, centros de datos y otros; y dinámica de la industria regional, tamaño del mercado y pronóstico de oportunidades para 2025-2033

- Última actualización: 30 de enero de 2025 | | ID del informe: AA0322178

Dinámica del mercado

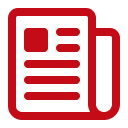

El mercado de memoria de alto ancho de banda está listo para un crecimiento significativo, y se espera que los ingresos aumenten de US $ 501.0 millones en 2024 a US $ 5,810.5 millones para 2033, a una tasa compuesta anual del 31.3% durante el período de pronóstico 2025-2033.

La memoria de alto ancho de banda (HBM) se encuentra en el centro de los cambios transformadores en la potencia informática a partir de 2024. AMD introdujo su serie MI300 con velocidades de datos máximas que se acercan a 5 terabytes por segundo en entornos de servidores cuidadosamente diseñados. SK Hynix reveló un prototipo HBM3 con una tasa de transferencia por pila de 819 gigabits por segundo en módulos HPC seleccionados. NVIDIA desplegó HBM2E en GPU de centro de datos insignia, alcanzando una frecuencia de memoria de 2.4 GHz en cargas de trabajo de IA específicas. HPC Labs en Alemania informó una mejora de latencia de 21 nanosegundos con paquetes HBM3 más nuevos, mientras que Samsung presentó una alineación de mediados de 2024 HBM que otorgó 24 gigabits por capa para apoyar aplicaciones emergentes de aprendizaje profundo. El impulso se aceleró aún más cuando la supercomputadora de Leonardo en Italia adoptó 74 aceleradores AMD equipados con HBM integrado para simulaciones climáticas, cada acelerador contiene alrededor de 15 gigabytes de memoria avanzada para análisis en tiempo real.

Una startup de IA con sede en Tokio en el mercado de memoria de alto ancho de banda aprovechó las 9 GPU H100 H100 que contienen HBM2E para manejar tareas expansivas de aprendizaje profundo. En una conferencia de 2024 HPC, una demostración mostró un chip basado en HBM que mantiene 2.78 terabytes por segundo en flujos de trabajo centrados en la memoria. Con el diseño de HBM reduciendo la energía por bit transferida, muchas empresas impulsadas por IA lo están adoptando para los próximos proyectos de HPC. Este amplio interés en HBM se ve impulsado por su capacidad para aumentar los límites de memoria tradicionales para las operaciones intensivas en datos. Los investigadores ven ganancias significativas en simulaciones de fluidos, análisis del genoma y otros escenarios que exigen un alto rendimiento constante. Una vez relegado a dispositivos de nicho, HBM ahora atrae una amplia atención para resolver la regulación de voltaje, el manejo térmico y las preocupaciones de eficiencia energética sin comprometer la velocidad. Los expertos de la industria esperan una mayor optimización de cooperativa de hardware para que las capacidades de HBM permanezcan completamente aprovechadas, señalando un futuro cercano de soluciones informáticas integradas y expertas en energía. Estos desarrollos forjan una ruta donde las interfaces de memoria avanzada sirven como pilares esenciales para los avances de HPC de próxima generación, asegurando que HBM conserve su posición como un diferenciador clave en los mercados modernos basados en datos.

Para obtener más información, solicite una muestra gratuita

Expansión del rayo de las líneas de producción

La capacidad de producción en el mercado global de memoria de alto ancho de banda ha aumentado en los últimos años a medida que varios fabricantes se apresuran a satisfacer la creciente demanda de soluciones de memoria avanzadas. Samsung planea aumentar su producción máxima de HBM a entre 150,000 y 170,000 unidades por mes para el cuarto trimestre de 2024. En conjunto, Micron tiene como objetivo aumentar su capacidad de producción de HBM en su planta de Hiroshima a 25,000 unidades en el mismo período de tiempo. Se espera que la capacidad de producción combinada de los tres principales fabricantes, Samsung, SK Hynix y Micron, alcance aproximadamente 540,000 unidades por mes para 2025. Solo hogar de 2,670 centros de datos, seguido por el Reino Unido en 452 y Alemania en 443.

Para acomodar estos volúmenes ascendentes, los principales jugadores en el mercado de memoria de alto ancho de banda están actualizando las instalaciones existentes y construyendo otras nuevas. Samsung está mejorando sus instalaciones de Pyeongtaek en Corea del Sur para escalar la producción de DDR5 y HBM, asegurando una tubería más robusta para la tecnología. Mientras tanto, SK Hynix continúa operando su línea de producción M16 en Icheon para HBM y también está construyendo una nueva instalación de fabricación en Indiana, EE. UU., Para producir pilas de HBM personalizadas para las GPU NVIDIA. Micron, por su parte, sigue comprometido a aumentar su capacidad de producción en su planta de Hiroshima en Japón, capitalizando la experiencia de fabricación establecida de la región. Estas expansiones subrayan un esfuerzo concertado de los líderes del mercado para mantenerse por delante de la curva tecnológica y satisfacer la creciente demanda global. A través de inversiones generalizadas en infraestructura, las empresas están preparando el escenario para una nueva era de tecnología de memoria, lo que impulsa la adopción más rápida entre las industrias que dependen de la potencia computacional de vanguardia.

Dinámica del mercado

Conductor: búsqueda implacable de velocidades de primer nivel para arquitecturas HPC especializadas con soluciones de memoria moderna integradas

La búsqueda implacable de velocidades de nivel superior para arquitecturas HPC especializadas con soluciones de memoria modernas integradas surge de la necesidad constante de manejar enormes volúmenes de datos y cálculos altamente complejos. Los principales fabricantes de chips en el mercado de memoria de alto ancho de banda han introducido nuevos módulos HBM específicamente para dirigir tareas como modelado climático, sistemas autónomos y simulaciones cuánticas. Intel mostró un acelerador prototipo en 2024 que demostró un rendimiento sostenido de 1.9 terabytes por segundo bajo inferencia de IA intensiva en memoria. Los diseñadores de la instalación de HPC de Bangalore informaron que un enfoque basado en HBM recortó la simulación de los tiempos de ejecución hasta 19 minutos para ciertos proyectos de dinámica de fluidos a gran escala. GraphCore confirmó que su IPU experimental que ejecuta HBM podría procesar un millón de bordes de gráficos en 2 segundos bajo pruebas de cifrado especializadas. Estos avances enfatizan la urgencia del mercado de adoptar soluciones de memoria más rápidas orientadas al ancho de banda que amplifican el rendimiento en los grupos HPC.

Esta unidad para el rendimiento acelerado también se cruza con la aparición de envases múltiples, lo que permite una integración más plegable entre compute y componentes de memoria. El nodo HPC recientemente desarrollado de Fujitsu aprovechó un subsistema HBM que transfirió 19 gigabytes de datos en 1 segundo de operación sostenida, abriendo puertas para el análisis avanzado de plegado de proteínas. TSMC ha producido un interposer especializado con micro-bumps espaciados en 30 micrómetros para facilitar las transferencias de señal ultra rápidas en diseños basados en HBM. Otro caso notable en el mercado de la memoria de alto ancho de banda involucra un instituto de astrofísica en Francia que logró un análisis en tiempo real de los datos del púlsar al aprovechar un motor alimentado por HBM que ofrece una latencia media de 110 nanosegundos. Al refinar las interconexiones y optimizar las topologías del sistema, la industria asegura que HBM permanezca en el núcleo del progreso de HPC, impulsando efectivamente la adopción en el futuro previsible.

Tendencia: Adopción creciente de plataformas integradas de acelerador-memoria para capacitar a un aprendizaje profundo avanzado y una sinergia HPC

En el sector de memoria de alto ancho de banda, una tendencia cada vez más visible es la creciente dependencia de los diseños de memoria aceleradora unificada que optimizan el flujo de datos para cargas de trabajo AI, HPC y Edge. Los aceleradores de instinto de AMD recientemente incluyeron una solución HBM en el paquete que admite cálculos de alto rendimiento para el modelado molecular en los laboratorios suizos. Xilinx, ahora parte de AMD, presentó un prototipo de matriz de puerta programable en campo que cuenta con intercambio de datos casi instantáneo entre Logic y HBM, lo que permite que múltiples redes neuronales se ejecuten simultáneamente en el mercado de memoria de alto ancho de banda. Las cerebras han demostrado un motor a escala de obleas emparejado con módulos HBM densos para manejar más de 2.5 millones de parámetros en tareas de aprendizaje de refuerzo sin transferencias fuera de chip. Esta alineación de la aceleración y la memoria de alta velocidad anuncia una nueva frontera en la eficiencia informática, fomentando soluciones avanzadas para industrias intensivas en datos.

A medida que la industria evoluciona, los marcos y bibliotecas especializados están cada vez más optimizados para explotar los canales de memoria unidos. El clúster HPC avanzado de OpenAI aplicó una arquitectura habilitada para HBM para realizar una capacitación en modelo de lenguaje a gran escala con hasta 2 billones de tokens procesados en una sola ejecución continua. Otro punto destacado significativo en el mercado de la memoria de alto ancho de banda provino de investigadores de robóticos con sede en Beijing que aprovecharon una sinergia de HBM y GPU Compute para lograr la toma de decisiones de subconocres en los controladores humanoides. La división HPC de Alibaba Cloud informó que las instancias de HPC de próxima generación con HBM grabaron una utilización de ancho de banda de 98 gigabytes por segundo en tareas basadas en el cifrado. Estos ejemplos subrayan un cambio de barrido hacia los ecosistemas integrados de aceleradores-memoria, marcando una transición fundamental en HPC y AI, mientras establece las bases para futuros avances en el análisis de datos en tiempo real.

Desafío: Mitigando el estrés térmico en las arquitecturas de matriz apiladas para preocupaciones continuas de estabilidad de la memoria de alto ancho de banda

Un desafío importante en el mercado de memoria de alto ancho de banda implica el control de la acumulación de calor en capas de memoria densamente apiladas. Los fabricantes de chips observan que las tareas de HPC extendidas generan una acumulación térmica sustancial, influyendo en la confiabilidad y el rendimiento. Un centro de simulación aeroespacial en Japón documentó temperaturas de componentes HBM que promedian 83 grados Celsius durante el análisis aerodinámico de varias horas. Para abordar esto, Samsung creó un material de interfaz térmica especializado que reduce los niveles de calor en alrededor de 8 grados en nodos HPC meticulosamente probados. Una agencia de investigación de defensa en Israel validó una configuración de refrigeración por agua que sostuvo la operación de memoria estable durante al menos 72 horas continuas de procesamiento de criptografía. Estos hallazgos afirman que la mitigación del calor sigue siendo una prioridad, asegurando que las estructuras apiladas no sufran de estrangulamiento de rendimiento o degradación de los componentes.

Las soluciones de gestión térmica en el mercado de memoria de alto ancho de banda también afectan el factor de forma y la arquitectura general del sistema, ya que HBM se encuentra muy cerca de los recursos de cálculo. SK Hynix introdujo una variante HBM2E que incorporó un canal de refrigerante de micro captura que transporta 1.1 litros de fluido por hora, mitigando los puntos de acceso durante la inferencia de IA. Una tecnología de cámara de vapor probada de consorcio HPC estadounidense contigua a la pila de memoria, logrando un ancho de banda constante en cargas de trabajo extendidas tan grandes como 2.3 conjuntos de datos a escala de petabyte. Los ingenieros de un instituto de investigación belga observaron que sin enfriamiento avanzado, las tasas de error de HBM aumentaron a 19 ocurrencias por millón de transacciones bajo puntos de referencia de estrés. La superación de estos obstáculos requiere la ciencia innovadora de los materiales, la ingeniería de precisión y la validación sólida del sistema que, en conjunto, ayudan a mantener un rendimiento estable para exigir implementaciones de HPC de próxima generación.

Análisis segmentario

Por producto: dominio de las CPU para mantenerse con vida hasta 2033

Las unidades de procesamiento central (CPU) consumen una participación notable de 35.4% en el mercado de memoria de alto ancho de banda debido a su papel integrado en la orquestación de tareas computacionales complejas en IA, análisis avanzados y ecosistemas de computación (HPC) de alto rendimiento (HPC). Al combinar HBM con CPU, las empresas obtienen capacidades de rendimiento de datos que superan los estándares de memoria convencionales, lo que permite más de 1 billón de operaciones de datos por minuto en ciertos entornos de HPC. En particular, la arquitectura 3D apilada de HBM admite hasta ocho módulos DRAM dentro de una sola pila, cada uno conectado por canales duales para flujos de datos sin obstáculos. En los diseños de CPU de vanguardia, esta configuración se traduce en velocidades de transferencia de pico que se acercan a 1 TB/s, lo que expedita drásticamente tareas como la capacitación en el modelo de aprendizaje automático. Además, algunas soluciones de CPU-HBM de próxima generación incorporan anchos de bus de hasta 1024 bits, lo que permite una transmisión simultánea de más de 100 mil millones de bits de datos desde la memoria hasta la CPU en un tiempo casi real. Dichos atributos técnicos mantienen la prominencia de la CPU en este dominio.

La creciente demanda de CPU equipadas con HBM en el mercado de memoria de alto ancho de banda también proviene de su papel en la reducción de la latencia y el consumo de energía en comparación con los sistemas de memoria paralelos. En aplicaciones intensivas en datos, una única combinación de CPU-HBM puede exhibir mejoras de ancho de banda de memoria de más del 40% en relación con las arquitecturas basadas en DDR tradicionales, acelerando enormemente los flujos de trabajo en la investigación científica y el modelado financiero. Otro punto destacado cuantitativo se encuentra en la elevación potencial de 2X a 3x en los cálculos de punto flotante una vez que HBM está estrechamente integrado con las tuberías de CPU centrales, aumentando el rendimiento computacional sin procesar del sistema. Esta sinergia alivia los cuellos de botella de memoria, ahorrando sistemas de la "pared de la memoria" y garantizar que los datos críticos se alimenten a velocidades óptimas. Con la aguda escasez de suministro de HBM informado en toda la industria, los principales fabricantes de CPU están priorizando la integración de HBM para mantener las métricas de rendimiento líderes en los procesadores de próxima generación. Estos factores aseguran colectivamente las CPU como la categoría de productos más importante que canalizan las excepcionales capacidades de banda de HBM y las capacidades de baja latencia en la informática moderna.

Aplicación: los centros de datos como el mayor consumidor del mercado de memoria de alto ancho de banda

Los centros de datos se han convertido en el mayor consumidor del mercado de memoria de alto ancho de banda con una participación de ingresos de más del 38.4% gracias a los volúmenes de información que se procesan en la computación en la nube, la inferencia de IA y el análisis de hiperescala en muchas instalaciones, los arquitectos de sistemas implementan los diseños de servidores que integran HBM para admitir tuberías de consulta capaces de 500 millones de búsquedas en tiempo real por segundo, lo que empodera las bases de datos críticas de la misión y las redes de entrega de contenido. En ciertas configuraciones, cada estante de servidor puede contener múltiples placas de aceleradores basadas en HBM, lo que permite el ancho de banda agregado que supera las 5 TB/s en implementaciones integrales. Mediante el uso de la memoria apilada, los centros de datos también reducen la huella física de las soluciones de memoria hasta un 30%, liberando espacio para una potencia de procesamiento adicional. Con velocidades que alcanzan 1 TB/s por pila de HBM, las tareas de procesamiento paralelas masivas, como la transcodificación de video o los análisis en tiempo real a gran escala, se completan con una mayor eficiencia y retrasos en el rendimiento reducido.

Otro factor contribuyente a la adopción del mercado de la memoria de alto ancho de banda de los centros de datos es el creciente énfasis en las cargas de trabajo impulsadas por la IA, donde capacitar un modelo de aprendizaje profundo puede involucrar miles de millones de parámetros y requerir múltiples terabytes de ancho de banda de memoria en la operación diaria. Al aprovechar HBM en los grupos de servidores, las empresas han informado de operaciones de inferencia que aceleran en más del 25%, reduciendo los tiempos de procesamiento de datos de manera meditable en comparación con los sistemas convencionales basados en DRAM. Incluso aplicaciones exigentes como bases de datos transaccionales ven un salto en el rendimiento de la memoria, con ciertas implementaciones que cortan latencias de lectura-escritura en cinco microsegundos en comparación con las soluciones de memoria estándar. Además, HBM reduce la demanda de energía en grandes centros de datos en aproximadamente un 10% por componente de memoria, ahorrando a las instalaciones decenas de miles de kilovatios-hora anualmente y apoyando objetivos generales de sostenibilidad.

Personalizar este informe + Validar con un experto

Acceda solo a las secciones que necesita: específicas de la región, a nivel de la empresa o por caso de uso.

Incluye una consulta gratuita con un experto en dominio para ayudar a guiar su decisión.

Para comprender más sobre esta investigación: solicite una muestra gratuita

Análisis regional: Asia Pacífico como el mercado de memoria de mayor ancho de banda más grande

Asia Pacific mantiene el primer lugar en la arena de memoria de alto ancho de banda, alimentado por una confluencia de fuertes redes de fabricación, demanda robusta de electrónica de consumo y respaldo masivo en el gobierno para la I + D de semiconductores. La región está preparada para crecer a una tasa compuesta anual de 37.7% en los próximos años. En 2022, la región generó más de US $ 55.24 millones en ingresos, que ahora alcanzó US $ 198.20 millones en 2024. Muestra que la región ha superado el dominio de América del Norte en el mercado. En donde, algunos de los jugadores clave, como Samsung Electronics y SK Hynix, mantienen instalaciones de fabricación avanzadas que producen colectivamente millones de unidades HBM cada trimestre, colocando la región como una potencia de producción de memoria de vanguardia. Entre los países que conducen este impulso, China, Corea del Sur y Japón tienen cadenas de suministro sofisticadas capaces de entregar tecnología HBM a los mercados nacionales y globales. En toda China, los incentivos políticos han estimulado el desarrollo de nuevas plantas de fabricación que pueden generar hasta 200,000 obleas de silicio por mes, una cifra que ha crecido constantemente a medida que la nación tiene como objetivo aumentar su autosuficiencia en los componentes semiconductores. Mientras tanto, el liderazgo de Corea del Sur en la investigación de la memoria y la capacidad de fabricación de precisión de Japón completan una tríada de fortalezas regionales. Esta alineación garantiza que Asia Pacífico sigue siendo un centro central para los envíos de memoria a escala empresarial, impulsando el dominio de la región en la producción de HBM.

La demanda en el mercado de memoria de alto ancho de banda de Asia Pacífico surge de aumentar las cargas de trabajo de IA y las implementaciones de HPC en las industrias, que se extienden desde biotecnología hasta conducción autónoma, requerir módulos de memoria capaces de impulsar más de 500 millones de transacciones de datos por segundo. Además, muchas de las expansiones de centros de datos más grandes del mundo están ocurriendo en APAC, donde los gigantes comerciales adoptan HBM para disminuir el consumo de energía de 15 a 20 vatios por módulo en relación con las interfaces de memoria típicas. China, en particular, se ha convertido en un líder estratégico al expandir los grupos de HPC en sectores como la secuenciación del genoma y el pronóstico del tiempo, lo que requiere soluciones de memoria extremadamente rápidas para tareas de simulación de datos. Los principales actores, incluidos Samsung, SK Hynix y las instalaciones regionales de Micron, refinan continuamente las tecnologías de próxima generación como HBM3E para mejorar las densidades de memoria y las velocidades de transferencia de datos que alcanzan 1.4 TB/s en los próximos lanzamientos. Con amplias bases industriales de alta tecnología, APAC no solo satisface las necesidades domésticas sino que también envía grandes cantidades de HBM a nivel mundial, anclando su lugar como la región preeminente para la innovación y el suministro de la memoria de alto ancho de banda.

Las principales compañías en el mercado de memoria de alto ancho de banda:

- Microdispositivos avanzados, Inc.

- Samsung Electronics Co., Ltd.

- SK Hynix Inc.

- Tecnología Micron, Inc.

- Rambus.com

- Corporación Intel

- Xilinx Inc.

- Silicio abierto (SiFive)

- Corporación NEC

- Sistemas de diseño de cadencia, Inc.

- Otros jugadores destacados

Descripción general de la segmentación del mercado:

Por producto:

- Unidad Central de Procesamiento

- Matriz de puertas programables en campo

- Unidad de procesamiento de gráficos

- Circuito integrado para aplicaciones específicas

- Otros

Por aplicación:

- Computación de alto rendimiento (HPC)

- Redes y espacio para clientes

- Centros de datos

- Otros

Por región:

- América del norte

- Estados Unidos

- Canadá

- México

- Europa

- el reino unido

- Alemania

- Francia

- Italia

- España

- Polonia

- Rusia

- Resto de Europa

- Asia Pacífico

- Porcelana

- India

- Japón

- Australia y Nueva Zelanda

- ASEAN

- Resto de Asia Pacífico

- Medio Oriente y África (MEA)

- Emiratos Árabes Unidos

- Arabia Saudita

- Sudáfrica

- Resto de MEA

- Sudamerica

- Argentina

- Brasil

- Resto de Sudamérica

ALCANCE DEL INFORME

| Atributo del informe | Detalles |

|---|---|

| Valor del tamaño del mercado en 2024 | US $ 501.0 mn |

| Ingresos esperados en 2033 | US $ 5,810.5 mn |

| Datos históricos | 2020-2023 |

| Año base | 2024 |

| Período de pronóstico | 2025-2033 |

| Unidad | Valor (millones de dólares) |

| CAGR | 31.3% |

| Segmentos cubiertos | Por producto, por aplicación, por región |

| Empresas clave | Advanced Micro Devices, Inc., Samsung Electronics Co., Ltd., SK Hynix Inc., Micron Technology, Inc., Rambus.com, Intel Corporation, Xilinx Inc., Open-Silicon (SiFive), NEC Corporation, Cadence Design Systems , Inc., otros jugadores destacados |

| Alcance de personalización | Obtenga su informe personalizado según sus preferencias. Preguntar por la personalización |

¿BUSCA CONOCIMIENTO INTEGRAL DEL MERCADO? CONTRATE A NUESTROS EXPERTOS ESPECIALISTAS.

HABLA CON UN ANALISTA

.svg)