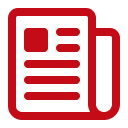

Marché de la mémoire à large bande passante : par produit (unité centrale de traitement, FPGA, unité de traitement graphique, circuit intégré spécifique et autres) ; application (calcul haute performance (HPC), réseaux et postes clients, centres de données et autres) ; et région – Dynamique du secteur, taille du marché et prévisions des opportunités pour 2025-2033

- Dernière mise à jour : 30 janvier 2025 | | Numéro de rapport : AA0322178

Dynamique du marché

Le marché de la mémoire à large bande passante est sur le point de connaître une croissance significative, avec des revenus qui devraient passer de 501 millions de dollars US en 2024 à 5 810,5 millions de dollars US d’ici 2033, soit un TCAC de 31,3 % au cours de la période de prévision 2025-2033.

La mémoire à large bande passante (HBM) est au cœur des transformations majeures de la puissance de calcul dès 2024. AMD a lancé sa série MI300, offrant des débits de données de pointe approchant les 5 téraoctets par seconde dans des environnements serveurs soigneusement conçus. SK hynix a dévoilé un prototype HBM3 présentant un débit de transfert par couche de 819 gigabits par seconde dans certains modules HPC. NVIDIA a déployé la HBM2E dans ses GPU phares pour centres de données, atteignant une fréquence mémoire de 2,4 GHz pour des charges de travail d'IA ciblées. Des laboratoires HPC allemands ont rapporté une amélioration de la latence de 21 nanosecondes avec les nouveaux modules HBM3, tandis que Samsung a dévoilé une gamme HBM pour mi-2024 offrant 24 gigabits par couche afin de prendre en charge les applications émergentes d'apprentissage profond. Cette dynamique s'est encore accélérée lorsque le supercalculateur Leonardo, en Italie, a adopté 74 accélérateurs AMD équipés de HBM intégrée pour les simulations climatiques, chaque accélérateur disposant d'environ 15 gigaoctets de mémoire avancée pour l'analyse en temps réel.

Une startup d'IA basée à Tokyo, active sur le marché de la mémoire à large bande passante, a exploité neuf GPU NVIDIA H100 équipés de HBM2E pour gérer des tâches d'apprentissage profond complexes. Lors d'une conférence HPC en 2024, une démonstration a présenté une puce basée sur la HBM capable de maintenir un débit de 2,78 téraoctets par seconde dans des flux de travail axés sur la mémoire. Grâce à sa conception qui réduit la consommation d'énergie par bit transféré, la HBM est de plus en plus adoptée par les entreprises du secteur de l'IA pour leurs futurs projets HPC. Cet engouement pour la HBM s'explique par sa capacité à dépasser les limites de la mémoire traditionnelle pour les opérations gourmandes en données. Les chercheurs constatent des gains significatifs dans les simulations de fluides, l'analyse du génome et d'autres scénarios exigeant un débit élevé et constant. Autrefois réservée à des dispositifs de niche, la HBM suscite désormais un vif intérêt pour sa capacité à résoudre les problèmes de régulation de tension, de gestion thermique et d'efficacité énergétique sans compromettre la vitesse. Les experts du secteur anticipent une optimisation conjointe plus poussée entre le matériel et le logiciel afin d'exploiter pleinement le potentiel de la HBM, laissant entrevoir un avenir proche de solutions informatiques intégrées et économes en énergie. Ces développements ouvrent la voie à des interfaces mémoire avancées qui constituent des piliers essentiels pour les percées HPC de nouvelle génération, garantissant ainsi que la mémoire HBM conserve sa position d'élément de différenciation clé sur les marchés modernes axés sur les données.

Pour en savoir plus, demandez un échantillon gratuit

Expansion ultra-rapide des lignes de production

La capacité de production sur le marché mondial de la mémoire à large bande passante a explosé ces dernières années, les différents fabricants s'efforçant de répondre à la demande croissante de solutions de mémoire avancées. Samsung prévoit d'augmenter sa production maximale de HBM à 150 000 à 170 000 unités par mois d'ici le quatrième trimestre 2024. Parallèlement, Micron vise à porter sa capacité de production de HBM dans son usine d'Hiroshima à 25 000 unités sur la même période. La capacité de production combinée des trois principaux fabricants – Samsung, SK Hynix et Micron – devrait atteindre environ 540 000 unités par mois d'ici 2025. Cette course effrénée à l'augmentation de la production est également influencée par l'expansion des infrastructures de centres de données : les États-Unis comptent à eux seuls 2 670 centres de données, suivis du Royaume-Uni (452) et de l'Allemagne (443).

Pour répondre à ces volumes croissants, les principaux acteurs du marché de la mémoire à large bande passante modernisent leurs installations existantes et en construisent de nouvelles. Samsung renforce son site de Pyeongtaek, en Corée du Sud, afin d'accroître sa production de DDR5 et de HBM, garantissant ainsi un approvisionnement plus robuste pour cette technologie. De son côté, SK Hynix poursuit l'exploitation de sa ligne de production M16 à Icheon pour la HBM et construit également une nouvelle usine dans l'Indiana, aux États-Unis, pour produire des modules HBM personnalisés pour les GPU NVIDIA. Micron, quant à elle, reste déterminée à augmenter sa capacité de production dans son usine d'Hiroshima, au Japon, en tirant parti du savoir-faire industriel reconnu de la région. Ces expansions témoignent d'un effort concerté des leaders du marché pour conserver leur avance technologique et satisfaire la demande mondiale croissante. Grâce à d'importants investissements dans les infrastructures, les entreprises préparent le terrain pour une nouvelle ère de la technologie de la mémoire, favorisant une adoption plus rapide dans les secteurs qui dépendent d'une puissance de calcul de pointe.

Dynamique du marché

Objectif principal : atteindre des vitesses de pointe pour les architectures HPC spécialisées dotées de solutions de mémoire modernes intégrées

La recherche constante de performances optimales pour les architectures HPC spécialisées, intégrant des solutions de mémoire modernes, découle du besoin permanent de traiter d'énormes volumes de données et des calculs extrêmement complexes. Les principaux fabricants de puces du marché de la mémoire à large bande passante ont introduit de nouveaux modules HBM spécifiquement conçus pour des tâches telles que la modélisation climatique, les systèmes autonomes et les simulations quantiques. En 2024, Intel a présenté un prototype d'accélérateur démontrant un débit soutenu de 1,9 téraoctet par seconde lors d'inférences d'IA gourmandes en mémoire. Les concepteurs du centre de calcul haute performance de Bangalore ont rapporté qu'une approche basée sur la mémoire HBM avait permis de réduire les temps d'exécution de simulations à 19 minutes pour certains projets de dynamique des fluides à grande échelle. Graphcore a confirmé que son IPU expérimental fonctionnant avec la mémoire HBM pouvait traiter un million d'arêtes de graphe en 2 secondes lors de tests de chiffrement spécifiques. Ces avancées soulignent l'urgence pour le marché d'adopter des solutions de mémoire plus rapides et à large bande passante, capables d'amplifier les performances des clusters HPC.

Cette quête de performances accrues coïncide avec l'émergence du packaging multi-puces, qui permet une intégration plus compacte entre les composants de calcul et de mémoire. Le nouveau nœud HPC développé par Fujitsu exploite un sous-système HBM capable de transférer 19 gigaoctets de données en une seconde de fonctionnement continu, ouvrant ainsi la voie à des analyses avancées du repliement des protéines. TSMC a produit un interposeur spécialisé doté de microbilles espacées de 30 micromètres pour faciliter des transferts de signaux ultrarapides dans les conceptions basées sur la HBM. Autre exemple remarquable sur le marché de la mémoire à large bande passante : un institut d'astrophysique français a réalisé l'analyse en temps réel de données de pulsars grâce à un moteur HBM offrant une latence médiane de 110 nanosecondes. En perfectionnant les interconnexions et en optimisant les topologies des systèmes, l'industrie s'assure que la HBM reste au cœur des progrès du HPC, favorisant ainsi son adoption dans un avenir prévisible.

Tendance : Adoption croissante de plateformes intégrées accélérateur-mémoire pour favoriser la synergie entre l'apprentissage profond avancé et le calcul haute performance (HPC)

Dans le secteur de la mémoire à large bande passante, une tendance de plus en plus marquée est le recours croissant à des architectures accélérateur-mémoire unifiées, optimisant le flux de données pour l'IA, le calcul haute performance (HPC) et les applications en périphérie de réseau. Les accélérateurs Instinct d'AMD intègrent désormais une solution HBM sur puce, permettant des calculs à haut débit pour la modélisation moléculaire dans des laboratoires suisses. Xilinx, désormais filiale d'AMD, a présenté un prototype de FPGA (Field-Programmable Gate Array) offrant un échange de données quasi instantané entre la logique et la HBM, permettant ainsi l'exécution simultanée de plusieurs réseaux neuronaux sur le marché de la mémoire à large bande passante. Cerebras a démontré qu'un moteur à l'échelle d'une plaquette, associé à des modules HBM haute densité, pouvait gérer plus de 2,5 millions de paramètres dans des tâches d'apprentissage par renforcement, sans transferts hors puce. Cette synergie entre accélération et mémoire haute vitesse ouvre de nouvelles perspectives en matière d'efficacité informatique, favorisant le développement de solutions avancées pour les industries à forte intensité de données.

Avec l'évolution du secteur, les frameworks et bibliothèques spécialisés sont de plus en plus optimisés pour exploiter des canaux de mémoire interconnectés. Le cluster HPC avancé d'OpenAI a utilisé une architecture basée sur la mémoire HBM pour réaliser l'entraînement de modèles de langage à grande échelle, avec jusqu'à 2 000 milliards de jetons traités en une seule exécution continue. Autre fait marquant sur le marché de la mémoire à large bande passante : des chercheurs en robotique basés à Pékin ont exploité la synergie entre la mémoire HBM et le calcul GPU pour atteindre une prise de décision inférieure à la milliseconde dans les contrôleurs humanoïdes. La division HPC d'Alibaba Cloud a annoncé que les instances HPC de nouvelle génération équipées de mémoire HBM ont enregistré une utilisation de la bande passante de 98 gigaoctets par seconde pour des tâches de chiffrement. Ces exemples soulignent une évolution majeure vers des écosystèmes intégrés accélérateur-mémoire, marquant une transition cruciale dans le HPC et l'IA, et jetant les bases de futures avancées dans l'analyse de données en temps réel.

Défi : Atténuer les contraintes thermiques dans les architectures à puces empilées pour garantir la stabilité de la mémoire à large bande passante en continu

L'un des principaux défis du marché des mémoires à large bande passante réside dans la maîtrise de l'accumulation de chaleur au sein des couches de mémoire densément empilées. Les fabricants de puces constatent que les tâches HPC prolongées génèrent une importante accumulation thermique, affectant à la fois la fiabilité et les performances. Un centre de simulation aérospatiale japonais a enregistré des températures moyennes de 83 degrés Celsius pour les composants HBM lors d'analyses aérodynamiques de plusieurs heures. Pour y remédier, Samsung a créé un matériau d'interface thermique spécialisé qui réduit les niveaux de chaleur d'environ 8 degrés dans des nœuds HPC rigoureusement testés. Un organisme de recherche de défense israélien a validé un système de refroidissement liquide garantissant un fonctionnement stable de la mémoire pendant au moins 72 heures de traitement cryptographique continu. Ces résultats confirment que la gestion de la chaleur demeure une priorité absolue, afin d'éviter toute limitation de performances ou dégradation des composants des structures empilées.

Les solutions de gestion thermique sur le marché des mémoires à large bande passante ont également un impact sur le format et l'architecture système globale, car la mémoire HBM est située à proximité immédiate des ressources de calcul. SK hynix a introduit une variante HBM2E intégrant un canal de refroidissement à micro-couches transportant 1,1 litre de liquide par heure, atténuant ainsi les points chauds lors des inférences d'IA. Un consortium américain de calcul haute performance a testé une technologie de chambre à vapeur adjacente à la pile mémoire, obtenant une bande passante constante pour des charges de travail étendues allant jusqu'à des ensembles de données de l'ordre de 2,3 pétaoctets. Des ingénieurs d'un institut de recherche belge ont observé que, sans refroidissement avancé, le taux d'erreur de la mémoire HBM atteignait 19 occurrences par million de transactions lors de tests de charge. Surmonter ces obstacles nécessite des avancées en science des matériaux, une ingénierie de précision et une validation système rigoureuse, qui, ensemble, contribuent à maintenir des performances stables dans les implémentations HPC de nouvelle génération exigeantes.

Analyse segmentaire

Conséquence : La domination des processeurs devrait se maintenir jusqu'en 2033

Les processeurs (CPU) détiennent une part de marché remarquable de 35,4 % sur le marché de la mémoire à large bande passante, grâce à leur rôle essentiel dans l'orchestration de tâches de calcul complexes au sein des écosystèmes d'IA, d'analyse avancée et de calcul haute performance (HPC). En combinant la mémoire HBM aux CPU, les entreprises bénéficient de capacités de débit de données supérieures aux normes de mémoire conventionnelles, permettant d'atteindre plus de 1 000 milliards d'opérations de données par minute dans certains environnements HPC. Notamment, l'architecture 3D empilée de la HBM prend en charge jusqu'à huit modules DRAM au sein d'une même pile, chacun connecté par deux canaux pour des flux de données fluides. Dans les conceptions de CPU de pointe, cette configuration se traduit par des vitesses de transfert de pointe proches de 1 To/s, ce qui accélère considérablement des tâches telles que l'entraînement de modèles d'apprentissage automatique. De plus, certaines solutions CPU-HBM de nouvelle génération intègrent des largeurs de bus allant jusqu'à 1 024 bits, permettant la transmission simultanée de plus de 100 milliards de bits de données de la mémoire au CPU en temps quasi réel. Ces caractéristiques techniques maintiennent la position dominante des CPU dans ce domaine.

La demande croissante de processeurs équipés de mémoire HBM sur le marché de la mémoire à large bande passante s'explique également par leur capacité à réduire la latence et la consommation d'énergie par rapport aux systèmes de mémoire parallèle. Dans les applications gourmandes en données, une seule combinaison processeur-HBM peut offrir des gains de bande passante mémoire supérieurs à 40 % par rapport aux architectures DDR traditionnelles, accélérant considérablement les flux de travail dans la recherche scientifique et la modélisation financière. Autre avantage quantitatif : l'intégration étroite de la HBM aux pipelines du processeur permet d'améliorer potentiellement de 2 à 3 fois la vitesse des calculs en virgule flottante, augmentant ainsi le débit de calcul brut du système. Cette synergie élimine les goulots d'étranglement liés à la mémoire, évitant ainsi aux systèmes le « mur de la mémoire » et garantissant un accès optimal aux données critiques. Face à la pénurie critique de HBM signalée dans l'ensemble du secteur, les principaux fabricants de processeurs privilégient l'intégration de la HBM afin de maintenir des performances de pointe pour les processeurs de nouvelle génération. L'ensemble de ces facteurs place les processeurs au cœur de l'exploitation de la bande passante exceptionnelle et de la faible latence de la HBM dans l'informatique moderne.

Application : Les centres de données, principaux consommateurs du marché de la mémoire à large bande passante

Les centres de données sont devenus les principaux consommateurs du marché de la mémoire à large bande passante, avec une part de revenus de plus de 38,4 %, grâce à l'explosion des volumes d'informations traitées dans le cloud computing, l'inférence IA et l'analyse hyperscale. Dans de nombreuses infrastructures, les architectes système déploient des serveurs intégrant la mémoire HBM pour prendre en charge des pipelines de requêtes capables de traiter 500 millions de requêtes en temps réel par seconde, optimisant ainsi les bases de données critiques et les réseaux de diffusion de contenu. Dans certaines configurations, chaque baie de serveurs peut contenir plusieurs cartes d'accélération HBM, permettant une bande passante agrégée supérieure à 5 To/s dans les déploiements complets. Grâce à l'utilisation de mémoire empilée, les centres de données réduisent également l'encombrement physique des solutions de mémoire jusqu'à 30 %, libérant ainsi de l'espace pour une puissance de traitement supplémentaire. Avec des vitesses atteignant 1 To/s par pile HBM, les tâches de traitement massivement parallèle, telles que le transcodage vidéo ou l'analyse en temps réel à grande échelle, sont réalisées avec une efficacité accrue et des délais de transmission réduits.

Un autre facteur contribuant à l'adoption croissante de la mémoire à large bande passante dans les centres de données est l'importance grandissante accordée aux charges de travail basées sur l'IA. L'entraînement d'un seul modèle d'apprentissage profond peut impliquer des milliards de paramètres et nécessiter plusieurs téraoctets de bande passante mémoire au quotidien. En tirant parti de la mémoire HBM dans les clusters de serveurs, les entreprises ont constaté une accélération des opérations d'inférence de plus de 25 %, réduisant sensiblement les temps de traitement des données par rapport aux systèmes DRAM classiques. Même les applications exigeantes, comme les bases de données transactionnelles, bénéficient d'un gain de performance mémoire significatif, certains déploiements réduisant la latence de lecture/écriture de cinq microsecondes par rapport aux solutions mémoire standard. De plus, la mémoire HBM réduit la consommation d'énergie des grands centres de données d'environ 10 % par composant mémoire, permettant ainsi d'économiser des dizaines de milliers de kilowattheures par an et contribuant aux objectifs de développement durable.

Personnalisez ce rapport + faites-le valider par un expert

Accédez uniquement aux sections dont vous avez besoin : par région, au niveau de l’entreprise ou par cas d’utilisation.

Comprend une consultation gratuite avec un expert du domaine pour vous aider à prendre votre décision.

Pour en savoir plus sur cette recherche : demandez un échantillon gratuit

Analyse régionale : L'Asie-Pacifique, premier marché de la mémoire à large bande passante

La région Asie-Pacifique domine le marché des mémoires à large bande passante, grâce à la conjonction de solides réseaux de production, d'une forte demande en électronique grand public et d'un soutien gouvernemental massif à la R&D dans le domaine des semi-conducteurs. La région est promise à une croissance annuelle composée (TCAC) de 37,7 % dans les années à venir. En 2022, son chiffre d'affaires s'élevait à plus de 55,24 millions de dollars américains, un montant qui a atteint 198,20 millions de dollars américains en 2024. Cela démontre que la région a surpassé la domination de l'Amérique du Nord sur ce marché. Des acteurs clés tels que Samsung Electronics et SK Hynix disposent d'installations de fabrication de pointe qui produisent collectivement des millions d'unités HBM chaque trimestre, faisant de la région un pôle majeur de la production de mémoires de pointe. Parmi les pays moteurs de cette dynamique, la Chine, la Corée du Sud et le Japon possèdent chacun des chaînes d'approvisionnement sophistiquées capables de fournir la technologie HBM aux marchés nationaux et internationaux. Partout en Chine, des mesures incitatives ont favorisé la construction de nouvelles usines de fabrication capables de produire jusqu'à 200 000 plaquettes de silicium par mois, un chiffre en constante augmentation, le pays cherchant à renforcer son autonomie en matière de composants semi-conducteurs. Parallèlement, le leadership de la Corée du Sud dans la recherche sur la mémoire et le savoir-faire japonais en matière de fabrication de précision complètent un trio d'atouts régionaux. Cette combinaison garantit à l'Asie-Pacifique un rôle central dans les livraisons de mémoire à grande échelle, consolidant ainsi sa position dominante dans la production de mémoire HBM.

La demande sur le marché de la mémoire à large bande passante en Asie-Pacifique est alimentée par l'explosion des charges de travail d'IA et le déploiement du calcul haute performance (HPC) dans tous les secteurs, des biotechnologies à la conduite autonome. Ces technologies nécessitent des modules de mémoire capables de traiter plus de 500 millions de transactions de données par seconde. Par ailleurs, de nombreux centres de données parmi les plus importants au monde s'étendent en Asie-Pacifique, où les géants de l'informatique adoptent la mémoire HBM pour réduire leur consommation d'énergie de 15 à 20 watts par module par rapport aux interfaces mémoire classiques. La Chine, en particulier, est devenue un acteur stratégique majeur en développant ses clusters HPC dans des secteurs tels que le séquençage du génome et les prévisions météorologiques, ce qui exige des solutions de mémoire extrêmement rapides pour les tâches de simulation de données. Les principaux acteurs, notamment Samsung, SK Hynix et les centres régionaux de Micron, perfectionnent continuellement les technologies de nouvelle génération comme la HBM3E afin d'améliorer la densité de mémoire et les vitesses de transfert de données, qui atteindront 1,4 To/s dans les prochaines versions. Grâce à ses vastes bases industrielles de haute technologie, la région Asie-Pacifique satisfait non seulement les besoins nationaux, mais exporte également de grandes quantités de mémoire HBM à l'échelle mondiale, ce qui lui permet de s'imposer comme la région prééminente en matière d'innovation et de fourniture de mémoire à large bande passante.

Principales entreprises du marché de la mémoire à large bande passante :

- Dispositifs microélectroniques avancés, Inc.

- Samsung Electronics Co., Ltd.

- SK Hynix Inc.

- Micron Technology, Inc.

- Rambus.com

- Intel Corporation

- Xilinx Inc.

- Silicium ouvert (SiFive)

- NEC Corporation

- Cadence Design Systems, Inc.

- Autres joueurs importants

Aperçu de la segmentation du marché :

Par produit :

- Unité centrale de traitement

- Réseau de portes programmables sur site

- Unité de traitement graphique

- Circuit intégré spécifique à l'application

- Autres

Sur demande :

- Calcul haute performance (HPC)

- Réseautage et espace client

- Centres de données

- Autres

Par région :

- Amérique du Nord

- Les États-Unis.

- Canada

- Mexique

- Europe

- Le Royaume-Uni

- Allemagne

- France

- Italie

- Espagne

- Pologne

- Russie

- Le reste de l'Europe

- Asie-Pacifique

- Chine

- Inde

- Japon

- Australie et Nouvelle-Zélande

- ASEAN

- Reste de l'Asie-Pacifique

- Moyen-Orient et Afrique (MEA)

- Émirats arabes unis

- Arabie Saoudite

- Afrique du Sud

- Reste du Moyen-Orient

- Amérique du Sud

- Argentine

- Brésil

- Le reste de l'Amérique du Sud

PORTÉE DU RAPPORT

| Attribut du rapport | Détails |

|---|---|

| Valeur de la taille du marché en 2024 | 501 millions de dollars US |

| Revenus prévus en 2033 | 5 810,5 millions de dollars américains |

| Données historiques | 2020-2023 |

| Année de base | 2024 |

| Période de prévision | 2025-2033 |

| Unité | Valeur (en millions de dollars américains) |

| TCAC | 31.3% |

| Segments couverts | Par produit, par application, par région |

| Entreprises clés | Advanced Micro Devices, Inc., Samsung Electronics Co., Ltd., SK Hynix Inc., Micron Technology, Inc., Rambus.com, Intel Corporation, Xilinx Inc., Open-Silicon (SiFive), NEC Corporation, Cadence Design Systems, Inc., et autres acteurs majeurs |

| Étendue de la personnalisation | Obtenez votre rapport personnalisé selon vos préférences. Demandez une personnalisation. |

VOUS RECHERCHEZ UNE CONNAISSANCE APPROFONDIE DU MARCHÉ ? FAITES APPEL À NOS SPÉCIALISTES EXPERTS.

PARLEZ À UN ANALYSTE

.svg)